ラズパイでLLMは動くのか? ラズパイ5 8GBでの検証 Ollama

自分のPCでLLMを動かしたいんだけどなかなかスペックが足りないことありますよね.

そこで, 安価で入手できるラズパイを使って, LLMが動作するのか検証していきます.

具体的には, DeepSeek-R1, Llama3, Mistral, Rakuten, CyberAgentモデルを実行していきます.

※ ここでは, ラズパイ5 8GBのみを使用しています.

マシンのスペック

ここでは, 以下のものを使用していきます.

・ラズパイ5 8GB

・Ubuntu 20.04 LTS

・MicroSDカード : 64GB

LLMの動作方法

さっそくですがLLMを動作させていきましょう.

今回, Ollamaを使用してLLMを実行していきます.

まず, Ollamaのインストールをしていきます.

curl https://ollama.ai/install.sh | sh次に, モデルをダウンロードします.

ollama pull モデル名モデルを実行します.

※ モデルをpullせずに, runした場合, 自動でpullしてくれます

ollama run モデル名※「Cntrl + D」で停止

ダウンロードしたモデル一覧を表示したい場合は ..

ollama lsダウンロードしたモデルを削除したい場合は…

ollama rm モデル名検証結果

ollamaが提供している多くのモデルは, 量子化や蒸留がされており, 多くの7Bや8Bモデルでは, 実行することができます. ただし, 処理が重くなるため, 出力やモデルのロードには時間がかかります.

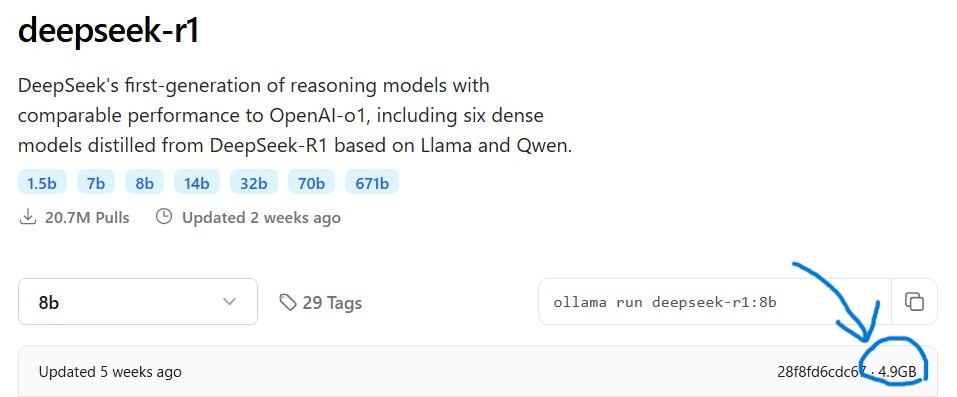

DeepSeek-R1:7b, Llama3.1:8b, Mistral:7b

これらのモデルは, 量子化されたものになります.

※ 詳しくは, ollamaのモデル一覧を見てください.

モデルのダウンロードには, 平均して20分ほどかかりました.

推論では, CPUの温度が60度ほどに上昇し, かくかくしましたが出力できました.

これらのモデルは, モデルのサイズが5GB以下と表記されており, ラズパイのメモリ容量である8GBであったため, 問題なかったと考えられます.

HuggingFace上のモデル(Rakuten:7b, CyberAgent:14b)

HuggingFace上に公開されているGGUF形式のモデルを実行していきます.

CyberAgent:14bモデルは, サイバーエージェント社がDeepSeek-R1を日本語に特化させて学習を行ったモデルになります.

実行コマンドを以下に示します.

ollama run hf.co/mradermacher/RakutenAI-7B-GGUFollama run hf.co/bluepen5805/DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf:Q3_K_LRakuten:7bモデルは実行することが出来ましたが, CyberAgent:14モデルはメモリーの容量が9.6GB必要であるため実行できませんでした.

ラズパイが欲しいなと思った方は, 以下の左に示す, ラズパイ5 8GBスターターキットがおすすめです. ラズパイはOSをダウンロードしたり, 初期設定のために, いろいろ部品が必要となりますが, 全て揃っています.

まとめ

Llama, Mistral, DeepSeek, Rakutenの8B以下のモデルでは, 少々遅延があったものの, ラズパイ上で実行できることが分かりました.