マルチモーダルLLMってなんだ? 簡単実装ガイド | プログラミング未経験でもOK! 完全無料のGoogle Colab,Groq API

「LLMは分かるけど、マルチモーダルLLMってなんだ?」という疑問にお答えします。

さらに、実際に触ってそのすごさを体感しましょう!

超簡単に実装できるようにしています。

ぜひ、プログラミングしたことのない方でも!

(分からないことがあったらサイト下部のコメント欄で教えてください🥺)

マルチモーダルLLMとは

マルチモーダルLLMとは、情報のタイプ(例えば、テキスト、音声、動画など)を2つ以上扱うことができるLLMのことをいいます。

近年の研究ではこのマルチモーダルに焦点を絞った研究も増えており、これからますます進化することが期待されています。

実際に触ってみましょう!

実装

マルチモーダルLLMを使用して、画像に含まれるものが何なのか出力してもらいましょう!

今回は完全無料で使用できる以下のサービスを利用します。

※もし、アカウント登録が完了していない場合、済ませておいてください。

今回Groq APIで利用できるモデル「llama-3.2-11b-vision-preview」を使用します。

実装手順

1. Groqのトークンを取得してください。※ 取得方法はこちらから

2. Google Colabで以下のプログラムをコピペしてください。※ YOUR_GROQ_API_KEYにはGroqのトークンを貼り付けてください。

import os

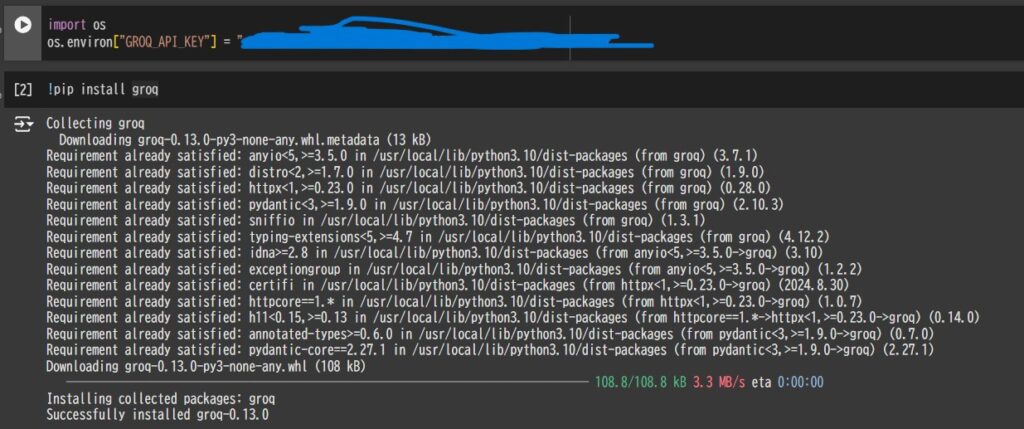

os.environ["GROQ_API_KEY"] = "YOUR_GROQ_API_KEY"!pip install groqGoogle Colabで1つのセルを実行するには「Shift+Enter」 もしくは「Cntrl+Enter」を使用します。

最終的に以下のような画面になればOK!

3.APIを実行するコードを貼り付けてください。画像に何が含まれているかを出力してくれます。

from groq import Groq

client = Groq()

completion = client.chat.completions.create(

model="llama-3.2-11b-vision-preview",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "What's in this image?"

},

{

"type": "image_url",

"image_url": {

"url": "https://user0514.cdnw.net/shared/img/thumb/039YAT1005_TP_V4.jpg?w=500,h=auto"

}

}

]

}

],

temperature=1,

max_tokens=1024,

top_p=1,

stream=False,

stop=None,

)

print(completion.choices[0].message)

最終的に、以下のような出力が得られたらOK! 以下の”content”が出力内容になります。

ChatCompletionMessage(content="出力内容", role='assistant', function_call=None, tool_calls=None)何の画像か分かりましたか?

他の画像も試したい方には、PAKUTASOがおすすめです。

“url”の内容を変更すると送られる画像が変更されます。

まとめ

実際に触ってみて、どうでしたか?

他にもたくさんのマルチモーダルLLMがあるので、調べて触ってみましょう!